去噪扩散概率模型

贡献者: xzllxls

预备知识 条件概率与事件的独立性(高中)

,高斯分布(正态分布)

,神经网络

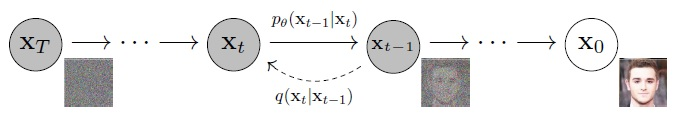

去噪扩散概率模型(Denoising Diffusion Probabilistic Models, DDPM)是一种参数化的马尔科夫链,通过变分推理的方法来训练。去噪扩散概率模型(后文简称扩散模型)是深度生成模型的一种,通常包含两个过程:第一是前向扩散过程,第二是反向的逆扩散过程。正反两个方向的马尔科夫链均由有限个时间步组成。其中,前向扩散过程就是一个无参数的马尔科夫链,而反向的逆扩散过程须要学习算法来训练模型。模型结构如图 1 所示。

图 1:去噪扩散概率模型的结构

设源数据为 $X_0$,$t$ 为时间变量,某个扩散过程中有 $T$ 个时间步.

前向扩散过程会逐渐向原数据添加小幅的高斯噪音,时间序列为:$t=0$ -> $1$ -> $2$ -> ... -> $T-1$ -> $T$.每一步所添加的高斯噪音的方差序列为:$\beta_1$, $\beta_2$, ..., $\beta_T$.

从 $t-1$ 到 $t$ 的转换概率为 $q( \boldsymbol{\mathbf{x}} _t| \boldsymbol{\mathbf{x}} _{t-1})$,则从源数据到扩散过程最后一步的转换概率为:

\begin{equation}

q( \boldsymbol{\mathbf{x}} _{1:T})=\prod_{t=1}^{T}q( \boldsymbol{\mathbf{x}} _{t}| \boldsymbol{\mathbf{x}} _{t-1})~.

\end{equation}

其中,

\begin{equation}

q( \boldsymbol{\mathbf{x}} _{t}| \boldsymbol{\mathbf{x}} _{t-1})=\mathcal{N}( \boldsymbol{\mathbf{x}} _t;\sqrt{1-\beta_t} \boldsymbol{\mathbf{x}} _{t-1},\beta_tI)~.

\end{equation}

反向的逆扩散过程是一个参数化的马尔科夫过程,每一步转换概率的参数通过神经网络模型学习而获得。时间序列为:$t=T$ -> $T-1$ -> ... -> $1$ -> $0$.逆过程的起点为时间步 t=T 时的带有噪音的数据,其数据分布为 $p_\theta( \boldsymbol{\mathbf{x}} _T)=\mathcal{N}( \boldsymbol{\mathbf{x}} _T;0,I)$.整个过程的转换概率为:

\begin{equation}

p_{\theta}( \boldsymbol{\mathbf{x}} _{0:T})=\prod_{t=1}^{T}p_{\theta}( \boldsymbol{\mathbf{x}} _{t-1}| \boldsymbol{\mathbf{x}} _{t})~,

\end{equation}

其中,

\begin{equation}

p_{\theta}( \boldsymbol{\mathbf{x}} _{t-1}| \boldsymbol{\mathbf{x}} _{t})=\mathcal{N}( \boldsymbol{\mathbf{x}} _{t-1};\mu_\theta( \boldsymbol{\mathbf{x}} _{t},t),\Sigma_\theta( \boldsymbol{\mathbf{x}} _t,t))~.

\end{equation}

参考文献:

- J. Ho, A. Jain, and P. Abbeel, “Denoising Diffusion Probabilistic Models,” in Advances in Neural Information Processing Systems, 2020, vol. 33, pp. 6840–6851.

致读者: 小时百科一直以来坚持所有内容免费无广告,这导致我们处于严重的亏损状态。 长此以往很可能会最终导致我们不得不选择大量广告以及内容付费等。 因此,我们请求广大读者

热心打赏 ,使网站得以健康发展。 如果看到这条信息的每位读者能慷慨打赏 20 元,我们一周就能脱离亏损, 并在接下来的一年里向所有读者继续免费提供优质内容。 但遗憾的是只有不到 1% 的读者愿意捐款, 他们的付出帮助了 99% 的读者免费获取知识, 我们在此表示感谢。